ChatGPT es probablemente el chatbot de inteligencia artificial (IA) más popular de los últimos años. Este servicio, que fue creado por la compañía OpenAI, permite al usuario tener una conversación con el fin de agilizar distintas tareas, como generar ideas o editar textos. Las posibilidades de esta IA han ido mejorando y, con la versión GPT-4, ya puede funcionar como asistente de voz y hablar.

Las implicaciones de que ahora ChatGPT pueda hablar y conversar con un tono muy cercano al de un humano han provocado que OpenAI realice una investigación interna sobre el efecto que podría tener en las personas. En un reciente informe, explicaron que algunos usuarios podrían ‘enamorarse’ del asistente de voz, lo cual supondría un peligro. ¿Cuáles son los riesgos? Aquí te lo explicamos.

¿Es posible que alguien se enamore de ChatGPT?

Antes de que OpenAI estrene la última versión GPT-4o de su chatbot, realizaron un trabajo de seguridad. Los resultados de esta evaluación los publicaron en un informe en el que se detalla los riesgos potenciales. Dentro de todos los apartados, hay uno que llama la atención por su particularidad: el nuevo asistente de voz de ChatGPT tiene cualidades que permiten la formación de vínculos emocionales con las personas.

Para ello, la compañía explicó todo lo que descubrieron en un apartado titulado ‘Antropomorfización y dependencia emocional’. En esta sección, OpenAI menciona los riesgos que implica atribuir comportamientos y características humanas a un modelo de IA. Esto se puede observar en el reciente asistente de voz de ChatGPT, el cual podría llevar a la confusión a las personas debido al tono casi humano con el que se expresa, lo que podría generar un lazo emocional o sentimental con el chatbot.

La compañía indica que las relaciones entre humanos pueden verse afectadas si una persona trata de la misma manera a un modelo de IA, como lo es ChatGPT. ‘Los usuarios pueden formar relaciones sociales con la IA, reduciendo su necesidad de interacción humana, lo que podría afectar las relaciones saludables’, explicó OpenAI.

Otro posible peligro de que alguien interactúe por un período largo con ChatGPT u otro modelo de IA es que la persona normalice la interrupción de lo que dice su interlocutor, como ocurre con los chatbots. Esto puede terminar por alterar las normas sociales que hay sobre la conversación entre seres humanos.

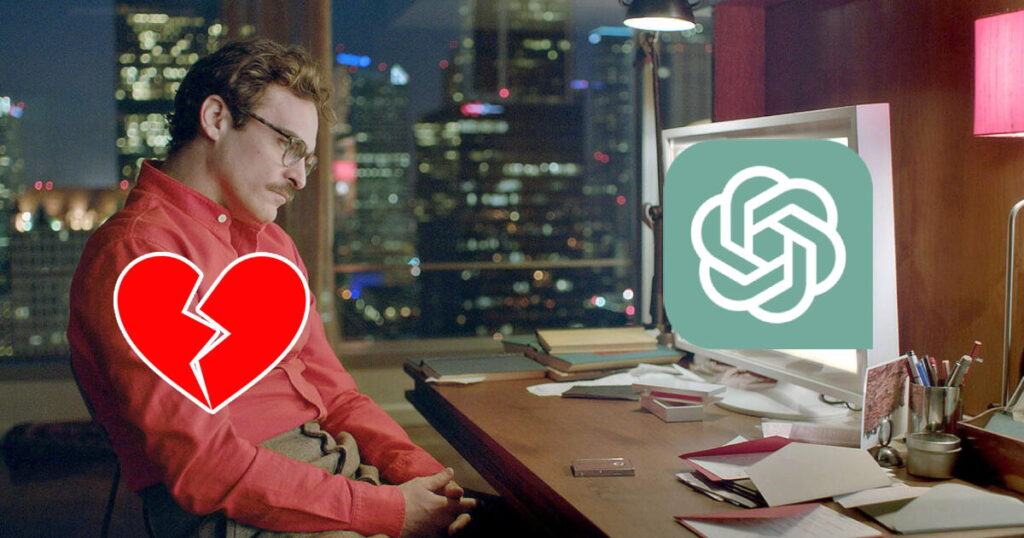

¿ChatGPT puede convertirse en Her?

Toda la situación descrita puede recordar a algunas personas lo que ocurre en ‘Her’. En esta película, el personaje principal, Theodore (interpretado por Joaquin Phoenix), inicia una relación con una asistente virtual llamada Samantha (interpretada por Scarlett Johansson), ya que no puede superar a su exesposa ni tampoco puede formar vínculos con otras mujeres.

De hecho, OpenAI utilizó una voz muy similar a la de Johansson para GPT-4o, lo cual les supuso una demanda legal por parte de la actriz. Este movimiento puede deberse a que la compañía sabía que la nueva versión del chatbot tiene la posibilidad de convertirse en una nueva Samantha.

‘Tenemos la intención de estudiar más a fondo el potencial de la confianza emocional y las formas en que una integración más profunda de las muchas características de nuestro modelo y sistemas con la modalidad de audio puede impulsar el comportamiento’, agregó OpenAI sobre este tema.